Kunstmatige intelligentie (AI) wordt al voor veel HR-doeleinden ingezet. Zo kan AI voorspellen wie er op zoek gaat naar een baan voordat iemand officieel begonnen is met zoeken. AI kan automatisch cv’s en motivatiebrieven scannen op zoekwoorden of taalgebruik en zo de meest geschikte kandidaten voorselecteren. AI-robots kunnen sollicitatiegesprekken voeren en beoordelen of kandidaten niet alleen over de juiste vaardigheden beschikken, maar ook over de juiste persoonlijkheid.

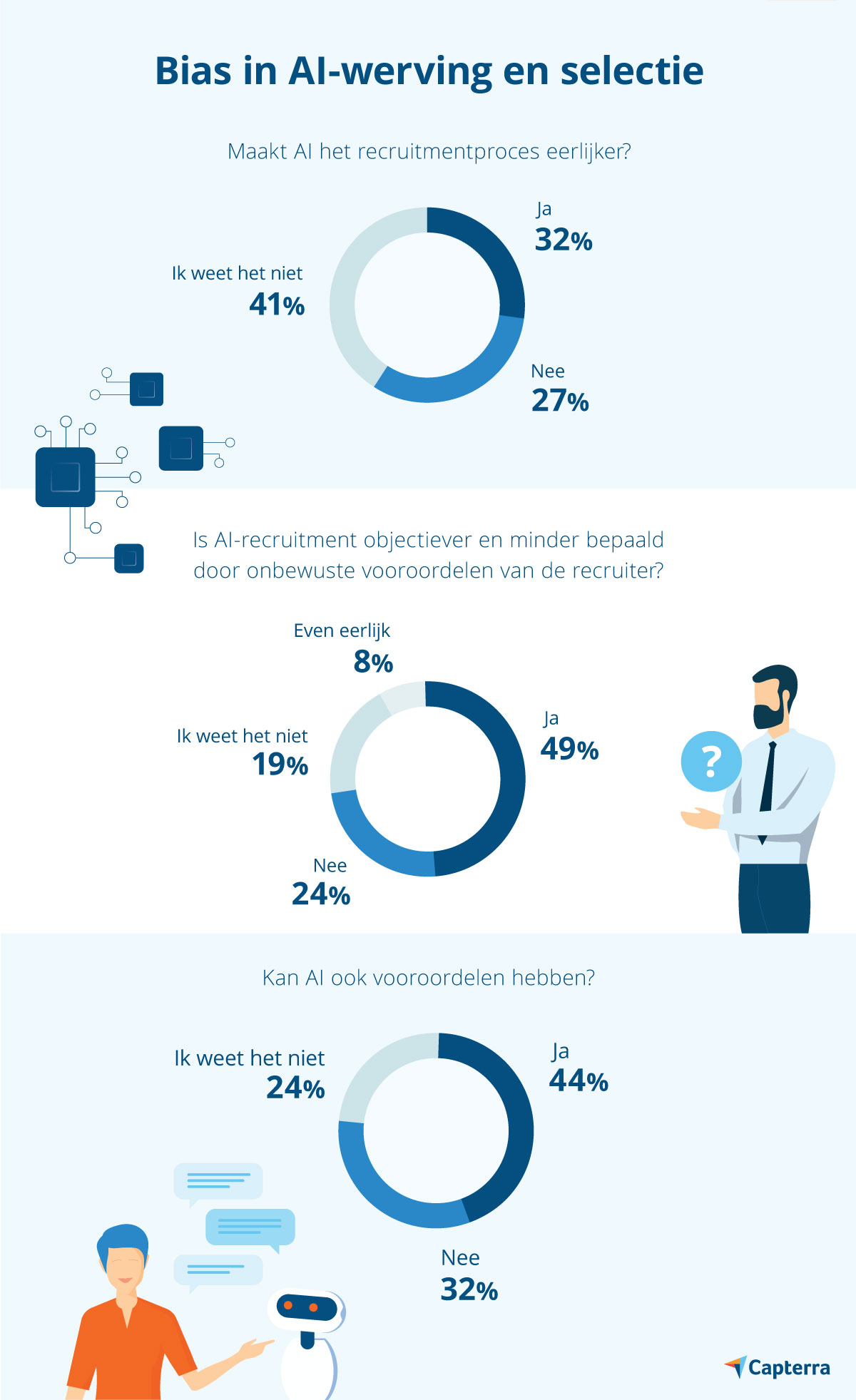

Veel mensen zijn bezorgd over dit gebruikvan AI-technologie. Veel sollicitanten vragen zich af hoe eerlijk het is als een machine cv's screent en bepaalt wie de meest geschikte kandidaten zijn. Is een machine eerlijker dan een recruiter? Kan AI ook vooroordelen hebben? Dit is wat men denkt en hoe het echt zit.

Cv-screening met AI

Voor HR-afdelingen die grote aantallen sollicitaties binnenkrijgen is handmatige cv-screening een tijdrovende klus. Het automatisch screenen van cv's met AI staat dan ook hoog op het verlanglijstje van recruiters. AI-screeningtools zoals Skillate of CVVIZ kunnen honderden cv's in seconden tijd doorspitten en filteren op trefwoorden met betrekking tot vaardigheden, ervaring of persoonlijke eigenschappen.

Om te bepalen welke kandidaten geschikt zijn past een machine learning AI-systeem ook de kennis toe die het heeft opgedaan uit eerdere ervaringen in werving en selectie. Het algoritme detecteert verwantschappen met bestaande succesvolle recruits en kan zo voorspellen wie de meest geschikte kandidaten zijn. De recruiter krijgt vervolgens een gekwalificeerde lijst met voorgeselecteerde sollicitanten.

Sollicitatiebots

Grote bedrijven zoals Unilever laten het interview zelfs al aan AI over. Sollicitanten werken een vaste vragenlijst af en het AI-systeem van HireVue neemt de antwoorden op. Vervolgens analyseert de tool deze op taalgebruik, intonatie en lichaamstaal. L'Oreál gebruikt de software van Seedlink om onbewuste patronen in het taalgebruik van kandidaten te analyseren en te weten te komen of de persoon past binnen hun bedrijfscultuur.

Is AI-recruitment eerlijk?

Of een selectieprocedure als eerlijk wordt ervaren door de kandidaten hangt enerzijds af van de mogelijkheid tot verificatie van de conclusies. Uit het onderzoek blijkt dat 68% van de respondenten de inzet van AI in de preselectie goed vindt zolang de resultaten maar worden herzien door een recruiter ter controle van de conclusies.

Anderzijds hangt het ook af van de transparantie en objectiviteit van het proces. En daar ontbreekt het momenteel nog vaak aan. De algoritmes die ten grondslag liggen aan de analyses zijn ondoorzichtig. De aard van machine learning AI is ten slotte dat het systeem zelf 'leert' en zelf verwantschappen ontdekt zonder dat daar een mens aan te pas komt. Dat maakt het zelfs voor ontwikkelaars moeilijk om hun systemen te doorgronden.

Kan AI discrimineren?

Naast transparantie speelt objectiviteit ook een belangrijke rol in hoe het wervingsproces wordt ervaren. Een van de redenen waarom AI wordt ingezet is juist om het selectieproces te verbeteren en niet meer te laten leiden door persoonlijke voorkeuren van een recruiter of onwetenschappelijke methodes. De vraag is echter of AI ook voorkeuren kan ontwikkelen.

AI kan vooroordelen hebben, afhankelijk van de data die het systeem krijgt. Machine learning algoritmes leren namelijk uit bestaande datasets of trainingsdatasets. Als deze onderliggende data (onbewuste) bias bevat (zoals het geval was bij Amazon) dan kan er wel degelijk sprake zijn van discriminatie. Werden er in het verleden bijvoorbeeld meer mannen dan vrouwen aangenomen voor een IT-functie, dan kan het algoritme dit patroon herkennen en het geslacht in aanmerking nemen als succesfactor voor die functie en zo onbedoeld discrimineren.

Deze directe vorm van AI-discriminatie is redelijk makkelijk te voorkomen door gevoelige informatie gewoon niet aan het systeem te geven.

Desondanks, zelfs als je het geslacht van kandidaten of andere discriminatiegevoelige kenmerken zou verbergen voor het systeem, kan AI toch nog indirecte bias ontwikkelen. Indirecte discriminatie ontstaat als het systeem op een andere manier een van bovenstaande eigenschappen afleidt en deze in aanmerking neemt. Een voorbeeld hiervan is als AI vaststelt dat lange sollicitanten succesvoller zijn dan kleinere sollicitanten. Omdat vrouwen over het algemeen kleiner zijn dan mannen, zouden vrouwen zo per ongeluk toch benadeeld kunnen worden. Vrouwen kunnen niet alleen aan hun lengte herkend worden, maar bijvoorbeeld ook door in hun cv te vermelden dat ze in een dameselftal spelen. Een bepaald geloof kan herkend worden door op een christelijke school te hebben gezeten. Indirecte discriminatie is veel moeilijker in te tomen, zelfs voor data scientists.

Kan AI-discriminatie voorkomen worden?

Om het algoritme biasvrij te maken is het van belang dat er genoeg diversiteit in de trainingsdata zit en dat er zo veel mogelijk historische data van kandidaten wordt verzameld. Kwantiteit voor kwaliteit dus.

Een andere manier om bias in het algoritme te voorkomen is het gebruik van software die vooroordelen in het AI-algoritme kan opsporen. Een voorbeeld van zo'n tool is IBM's AI Fairness 360. Deze open source tool bevat 70 'fairness-metrics' en 10 geavanceerde biasmatigingsalgoritmes om bias te voorkomen. Audit AI van Pymetrics is een ander voorbeeld van een open source tool die discriminerende patronen in trainingsgegevens kan meten en verminderen.

Ondanks deze maatregelen om AI-discriminatie te voorkomen, blijft het de vraag of AI de perfecte selectie kan uitvoeren. Er zijn tal van factoren die bepalen of een kandidaat een match is en niet alles staat in een cv of motivatiebrief. AI kan aanbevelingen doen, maar alleen een mens dient de uiteindelijke beslissing te nemen. Dat zal de beste manier blijven om bias te voorkomen. Dat vindt 68% van de respondenten van het Capterra-onderzoek. De inzet van AI in de voorselectie is prima zolang de resultaten maar worden herzien door een recruiter ter controle van de conclusies en om eerlijkheid te garanderen.

Gerelateerde artikelen

Bang voor robots of word je ze de baas?

Michel Geurts

Welk CV wordt als eerste uit de stapel sollicitaties geplukt?

Actueel MNGMNTST

Online beoordelings-systemen en gedragsverandering

Willem Mastenbroek

Deel uw ervaringen op ManagementSite

Wij zijn altijd op zoek naar ervaringen uit de praktijk, wat werkt wel, wat niet.

SCHRIJF MEE >>

Als u 3 of meer artikelen per jaar schrijft, ontvangt u een gratis pro-abonnement twv €200,--

Wanneer AI systemen gevoed worden met leugens, is het volledig onmogelijk om correcte conclusies te trekken en beslissingen te maken. En het gaat veel verder, want AI systemen kunnen uiteindelijk discriminerend staan t.o.v. 'normale' of wenselijke situaties.

Dit is volstrekt geen nieuw denkbeeld. Hetzelfde kan namelijk gezegd worden over en is bewezen bij het gebruik van statistische gegevens en het verwerken van die data in computermodellen. Als de gegevens niet correct of volledig zijn en/of de modellen onjuist, verouderd of zelfs geprogrammeerd naar een gewenst resultaat, dan heeft de resulterende output geen enkele reële waarde, sterker nog, er worden onjuiste conclusies aan verbonden, met alle gevolgen van dien.

Wanneer worden we wakker als het gaat om AI ? Het is heel gevaarlijk spul.